SLMとは?~LLMとの違いと環境構築の方法~

生成AI技術の進化に伴い、大規模言語モデル(LLM: Large Language Model)の重要性がますます高まっています。しかし、LLMはその高い性能を発揮するために膨大な計算リソースが必要であり、必ずしもすべての用途に適しているわけではありません。特にエッジデバイスやローカル環境での利用を考慮すると、SLM(Small Language Model、小規模言語モデル)の活用が注目されています。本コラムでは、SLMとLLMの違い、そしてSLMの環境構築方法について詳しく解説します。SLMの基本概念や代表的なモデルの紹介を通じて、リーズナブルな運用やリアルタイム処理が求められるシーンでのSLMの有用性を紹介します。

1. SLM(小規模言語モデル)とは

近年、生成AIの進化が目覚ましく、その中心にあるのが大規模言語モデル(LLM: Large Language Model)です。しかし、LLMは膨大な計算リソースを必要とし、運用コストも高いため、すべての用途に適しているわけではありません。そこで注目されているのが、SLM(Small Language Model、小規模言語モデル)です。SLMはLLMと比べてモデルのサイズが小さく、エッジデバイス(クラウドを介さずにデータ処理を行う端末)やローカル環境でも動作可能なため、リーズナブルに導入できることが期待されています。

1-1. SLMの基本概念

SLMとは、数億から数十億(10B以下)のパラメータを持つ比較的小規模な言語モデルのことを指します。LLMが数千億から数兆パラメータを有するのに対し、SLMはより軽量で、少ない計算資源でも動作可能なように設計されています。

この小型化は、知識蒸留(Knowledge Distillation)や量子化(Quantization)、剪定(Pruning)といった技術によって実現されます。知識蒸留では、大規模モデルの学習成果を小規模モデルに転写し、性能を維持しつつサイズを縮小します。量子化では、モデル内部の数値表現を低精度化することで計算量を削減し、剪定では不要なパラメータを削除することで軽量化を図ります。

SLMの特徴として、リーズナブルに運用が可能であること、リアルタイム処理が求められるエッジデバイスでも動作できること、またプライバシー保護の観点からデータをクラウドに送らずにローカルで処理できることが挙げられます。

1-2. 代表的なSLMの紹介

現在、多くのSLMが開発・公開されており、それぞれ特徴的な設計思想を持っています。

まず、Microsoftが開発した「Phiシリーズ」は、優れた性能を持つSLMとして知られています。Phi-3 Mini(約38億パラメータ)は、同規模の他のモデルと比較しても高い精度を誇り、エッジデバイスでの動作も考慮されています。

また、Stability AIの「Stable LM 2 1.6B」は、日本語にも対応した小規模モデルであり、多言語対応が求められる環境での活用が期待されています。さらに、「Mistral 7B」は、70億パラメータというコンパクトな設計ながら、大規模モデルと比較しても遜色ない精度を持つモデルとして注目されています。

このほか、Googleの「Gemma 7B」なども、SLMの代表例として広く利用されています。

2. LLMとSLMの比較

2-1. 性能と用途の違い

LLMとSLMは、それぞれ異なる用途に適しています。LLMは膨大なパラメータを持つため、幅広い知識を持ち、創造的な文章生成や高度な推論が可能です。一方、SLMは特定のタスクに最適化されることが多く、リソースの制約がある環境での利用に向いています。

例えば、クラウド上で大規模なAIサービスを提供する場合、LLMが適しています。ChatGPTなどのサービスは、その巨大なモデルによってユーザーの質問に対し、多様な知識を活用して回答を生成します。

一方で、企業内の機密情報を扱うチャットボットや、オフライン環境での利用を想定する場合、SLMが有力な選択肢となります。SLMはローカル環境での運用が可能なため、クラウドにデータを送ることなく、プライバシーを確保しながらAIを活用できます。

3. SLMのローカル環境構築方法を紹介

SLMの大きな利点のひとつは、ローカル環境でも動作が期待できることです。ここでは、実際にSLMをローカルで運用するための手順を紹介します。

3-1. 事前準備

SLMをローカル環境で動作させるためには、いくつかの事前準備が必要です。

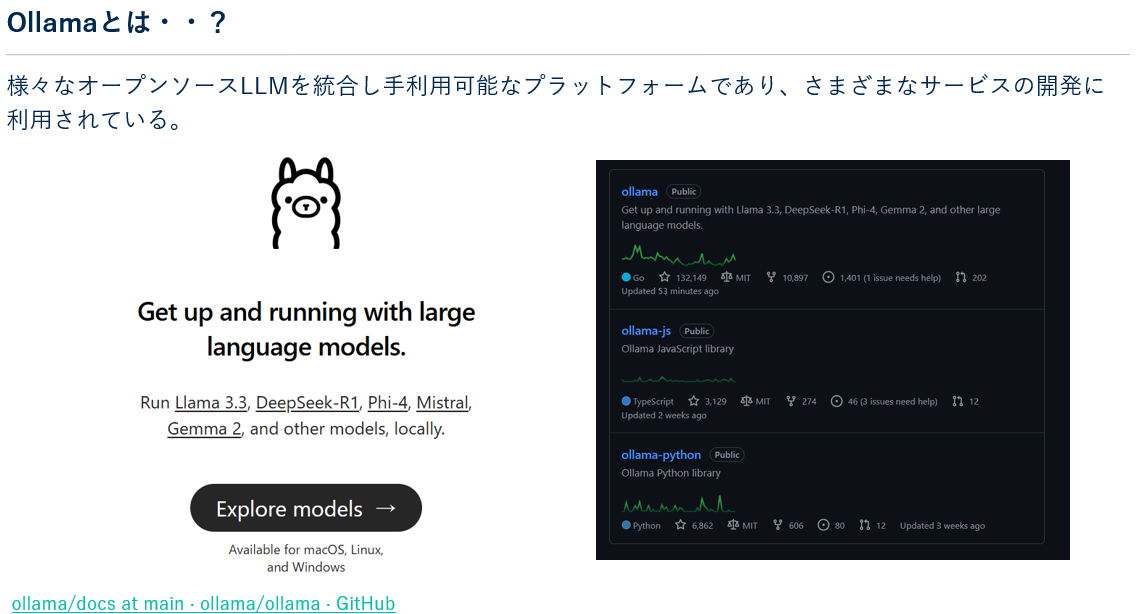

本コラムでは、ローカルPC環境で手軽に構築できるSLMの実行環境例を紹介します。具体的には、Windows上でWSLを利用してPython仮想環境を構築します。その上で、OSSであるOllamaという手軽にオープンソースLLMが利用できるソフトウェアを導入し、Pythonで実際にLLMに対して問い合わせを行うコードを実行してみます。事前にWSLでUbuntuのディストリビューションを利用できる状態にしておきます。

※先進のオープンソースモデルを簡単にダウンロードして使用することができます。

まず、ハードウェアとしては、最低でも8GB以上のRAMを持つPCが推奨されます。SLMはLLMほど大きなリソースを必要としませんが、それでもある程度の計算能力は必要です。

環境構築を行うローカルPCの情報は以下になります。

- OS:Windows 11

- メモリ:32GB

- GPU:NVIDIA GeForce RTX 4070

- CUDA Version: 12.8

- WSL:Python 3.12.3 (Ubuntu)

3-2. SLMの動作環境の構築手順

次にWSL(bash)での手順を紹介します。

ライブラリのアップデート・アップグレードを行います。

sudo apt update

sudo apt upgrade -y

仮想環境を作成します。

python3 -m venv venv仮想環境を開始します。

source venv/bin/activate

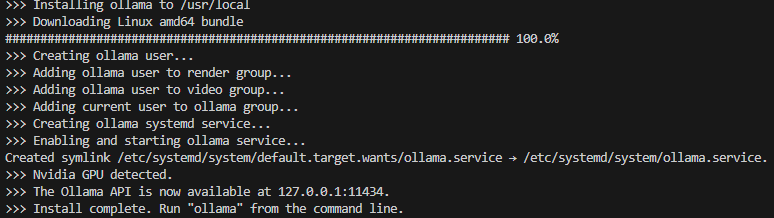

Ollamaをinstallします。

curl -fsSL https://ollama.com/install.sh | sh

インストールが完了したことを確認します。

ollama -vバージョン情報が表示されれば完了です。

次に利用するモデルをダウンロードします。今回はマイクロソフトの公開しているPhi-3を利用します。

※利用できるモデルはこちらhttps://github.com/ollama/ollama/blob/main/README.md#quickstart

モデルをダウンロードして起動します。

ollama run phi3最後にPythonのライブラリをインストールしてノートブックからの実行環境などを整えます。

pip install ollama3-3. 動作の評価

実際にSLMを動作させた後、適切な応答が得られるか評価することが重要です。

レスポンスタイムの計測では、モデルの応答速度を確認し、実用に耐えうるかを判断します。さらに、回答の正確性についても、人間の評価を交えながら、モデルが適切な回答を生成しているかをチェックします。加えて、メモリ使用量を監視し、システムの負荷を把握することで、安定した運用が可能かを検討します。

from ollama import chat

from ollama import ChatResponse

response: ChatResponse = chat(model='phi3', messages=[

{

'role': 'user',

'content': 'Azureについて100字で教えてください!',

},

])

print(response.message.content)

4. 生成AI活用にお悩みならNTT東日本にご相談ください

NTT東日本では、AI技術を活用したさまざまなソリューションを提供しています。 先進的な技術とサービスを活用し、貴社の業務効率化と競争力向上を図ってみませんか?詳細はNTT東日本へお問い合わせください。

5. まとめ

本コラムではSLM(小規模言語モデル)の紹介と、実際の動作環境の構築例を紹介しました。SLMは、LLMと比較して軽量かつリーズナブルに運用できる点が魅力であり、エッジデバイスやローカル環境での利用に適しています。また、オープンソースのモデルを活用することで、さまざまな用途に応じたカスタマイズが可能です。ローカル環境での運用を考える場合、OllamaやPyTorchを活用することで、簡単にSLMを動作させることができます。これからのAI活用の場面では、LLMとSLMを適材適所で使い分けることが重要となるでしょう。

生成AIの活用についてお悩みならNTT東日本にお気軽にご相談ください。

- Phi-3,Phi-3 miniは、Microsoft Corporationの米国及びその他の国における登録商標または商標です。

- Mistral 7B はMistral AI SASの商標または登録商標です。

- Gemmaは、Google LLC の商標または登録商標です。

無料ダウンロード

自社のクラウド導入に必要な知識、ポイントを

この1冊に総まとめ!

あなたはクラウド化の

何の情報を知りたいですか?

- そもそも自社は本当にクラウド化すべき?オンプレとクラウドの違いは?

- 【AWS・Azure・Google Cloud】

どれが自社に最もマッチするの? - 情シス担当者の負荷を減らしてコストを軽減するクラウド化のポイントは?

- 自社のクラウド導入を実現するまでの具体的な流れ・検討する順番は?

初めての自社クラウド導入、

わからないことが多く困ってしまいますよね。

NTT東日本では

そんなあなたにクラウド導入に必要な情報を

1冊の冊子にまとめました!

クラウド化のポイントを知らずに導入を進めると、以下のような事になってしまうことも・・・

- システムインフラの維持にかかるトータルコストがあまり変わらない。。

- 情シス担当者の負担が減らない。。

- セキュリティ性・速度など、クラウド期待する効果を十分に享受できない。。

理想的なクラウド環境を実現するためにも、

最低限の4つのポイントを

抑えておきたいところです。

-

そもそも”クラウド化”とは?

その本質的なメリット・デメリット - 自社にとって

最適なクラウド環境構築のポイント - コストを抑えるための

具体的なコツ - 既存環境からスムーズにクラウド化を

実現するためのロードマップ

など、この1冊だけで自社のクラウド化のポイントが簡単に理解できます。

またNTT東日本でクラウド化を実現し

問題を解決した事例や、

導入サポートサービスも掲載しているので、

ぜひダウンロードして読んでみてください。

面倒でお困りのあなたへ

クラウドのご相談できます!

無料オンライン相談窓口

NTT東日本なら貴社のクラウド導入設計から

ネットワーク環境構築・セキュリティ・運用まで

”ワンストップ支援”が可能です!

NTT東日本が選ばれる5つの理由

- クラウド導入を

0からワンストップでサポート可能! - 全体最適におけるコスト効率・業務効率の改善を

中立的にご提案 - クラウド環境に問題がないか、

第3者目線でチェック

してもらいたい - 安心の24時間・365日の対応・保守

- NTT東日本が保有する豊富なサービスの組み合わせで

”課題解決”と”コスト軽減”を両立

特に以下に当てはまる方はお気軽に

ご相談ください。

- さまざまな種類やクラウド提供事業者があってどれが自社に適切かわからない

- オンプレミスのままがよいのか、クラウド移行すべきなのか、迷っている

- オンプレミスとクラウド移行した際のコスト比較を行いたい

- AWSとAzure、どちらのクラウドが自社に適切かわからない

- クラウド環境に問題がないか、第3者目線でチェックしてもらいたい

- クラウド利用中、ネットワークの速度が遅くて業務に支障がでている

クラウドを熟知するプロが、クラウド導入におけるお客さまのLAN 環境や接続ネットワーク、

クラウドサービスまでトータルにお客さまのお悩みや課題の解決をサポートします。

相談無料!プロが中立的にアドバイスいたします

クラウド・AWS・Azureでお困りの方はお気軽にご相談ください。